La divulgadora científica española participa como voluntaria en la biblioteca del colegio donde estudia su hija. Ella cuenta que esta escuela implementó un programa, diseñado por la Comunidad de Madrid, en el que se registran todos los libros de cada biblioteca escolar y los nombres de cada niño que se lleva o devuelve un volumen prestado. Hasta entonces, ella apuntaba detalladamente ese servicio en clásicas fichas de papel. Pero las maestras, orgullosas, le informaron que ya podía tirar las fichas, pues el servicio sería mucho más eficiente si todo estaba informatizado.

Pero Laura G. de Rivera no aceptó el cambio. “No voy a meter el nombre de menores en los registros de la Comunidad de Madrid. ¿Qué les importa a ellos saber qué libros han cogido nuestros hijos? ¿Qué quieren hacer con estos datos?”, se preguntaba, manteniéndose fiel a su método analógico. Las docentes tuvieron que retroceder. Pero en el fondo, sabía que su victoria era pírrica. Conectar o no una pequeña biblioteca a la red de la ciudad es solo una de muchas decisiones que se toman sin pensar, dando por hecho que informatizar resulta siempre mejor.

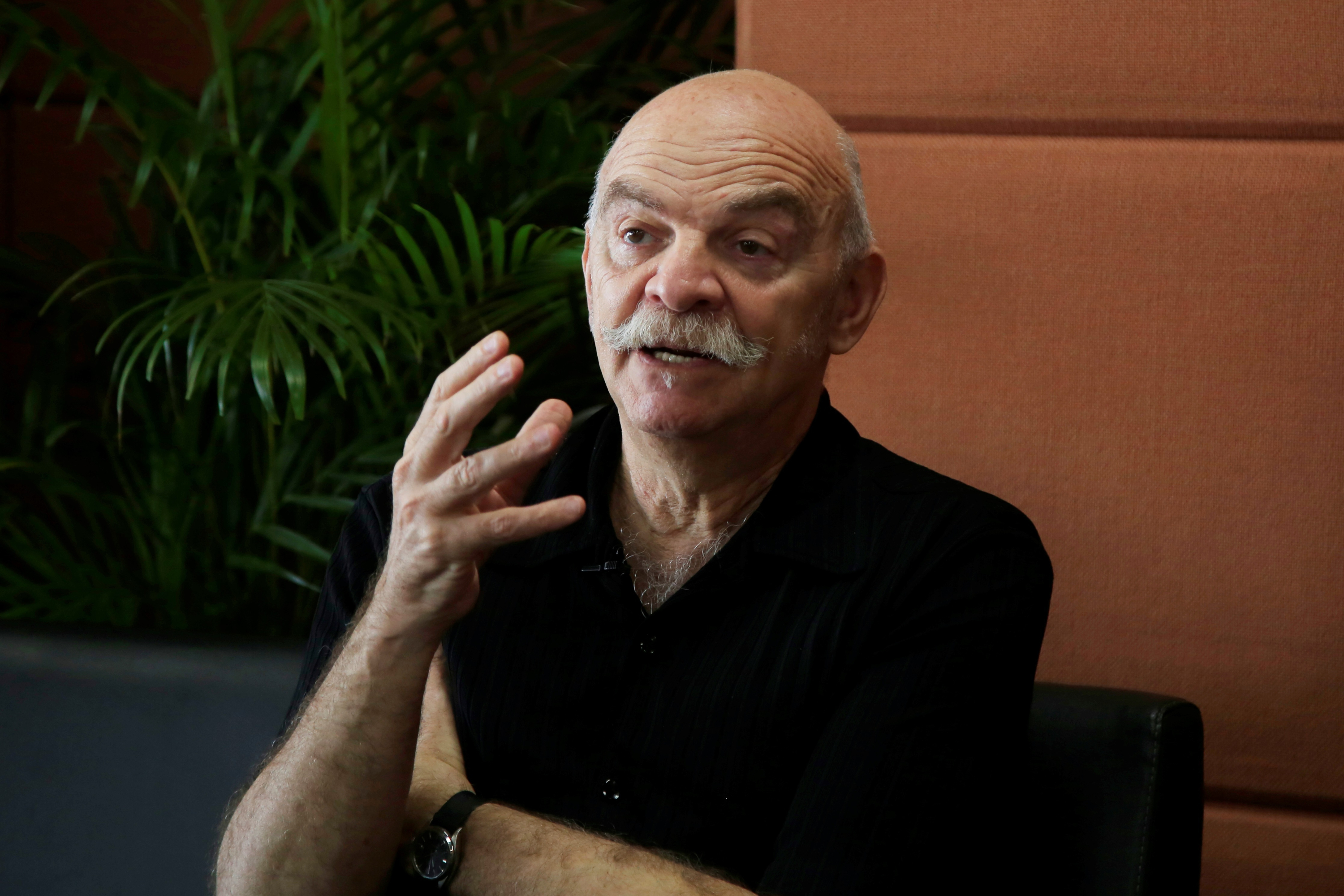

El Hay Festival de Arequipa (Perú) invitó a esta periodista española especializada en divulgación científica para hablar de su último libro: ‘Esclavos del Algoritmo: Manual de resistencia en la era de la inteligencia artificial’ (2025), un volumen en el que ella invita a detenerse a pensar. Ciertamente, se experimenta un temor durante la lectura al advertir la progresiva pérdida de nuestras libertades en nuestra relación con las redes sociales. Para su autora, no se trata de una historia espeluznante, sino de un informe sobre el estado de la cuestión y un listado de soluciones accesibles: la primera de ellas, pensar por uno mismo.

“Hay que recuperar el cerebro para entender cómo funcionan la inteligencia artificial (IA) y las plataformas digitales, y saber quién está detrás de ellas. Es una solución gratis, sin impacto medioambiental, y que lo puede hacer cualquiera. Para mí, es importante que el mensaje de este libro sea de esperanza. Frente a todo lo que está pasando, el antídoto es tan sencillo como apagar tu celular”, explica.

LEA TAMBIÉN

Permítame preguntarle cuántas veces le han dicho: “No sea paranoica”.

(Sonríe) ¡Mi hijo mayor me lo ha dicho muchas veces, pero le he ido demostrando que no tengo nada de paranoica! Por ejemplo, él pensaba que Google Maps nunca se equivocaba, hasta que, llevándolo a un examen muy importante y con el tiempo justo, él decidió apelar a Google Maps. Y el programa nos llevó a un descampado. Desde aquel día, después de llegar tarde a su examen, empezó a confiar más en la experiencia humana. Sucede igual cuando el consultor tecnológico Edward Snowden denunció que los sistemas de la inteligencia estadounidense estaban vigilando las comunicaciones de todo el planeta. Esto lo dices tú y suena a conspiranoia, un motivo para encerrarte en el psiquiátrico. Pero él demostró que era cierto. Si se puede demostrar, no es paranoia: es la verdad.

Hay ejemplos que comparte en su libro que resultan muy preocupantes. La guerra desinformativa parece un caos imposible de controlar. Sin embargo, demuestra que todo resulta dirigido de manera inteligente.

La desinformación es un tema que he investigado mucho. Por una parte, tienes a los gobiernos y políticos que buscan manejar la opinión pública creando millones de cuentas falsas para promocionar las virtudes de un candidato y la necesidad de votar por él. Y la gente lo cree. Las personas tenemos un talón de Aquiles: queremos encajar, no desentonar y seguir a la mayoría. Si en redes vemos a una mayoría afirmando algo, nos subimos a ese tren. El peligro es que esa mayoría puede no estar compuesta por personas reales, sino por bots: una inteligencia artificial programada para apoyar a un político. Esta es la desinformación intencionada. Pero también hay otro tipo de desinformación, todavía más grande, que no es intencionada. Es aquella que se crea simplemente por algoritmos de IA generativa. Por ejemplo, imaginemos una plataforma web cuyo algoritmo tiene la misión de tener a sus usuarios enganchados el mayor tiempo posible. Como Maquiavelo, para el algoritmo, el fin de tener a la gente pegada a la pantalla justifica los medios. El algoritmo va probando y va comprobando los patrones humanos y descubre que, cuanto más violenta, morbosa o sexual sea la información, la gente estará más entregada a la pantalla, retuiteando, indignándose y comentando. El algoritmo descubre que eso funciona y apuesta por ese contenido. No le importa que sea real o irreal. Así, la desinformación surge de la máquina, sin nadie detrás. Esto es tremendo, porque ya no hablamos de personas malvadas manipulando la opinión pública. Son algoritmos sueltos que están dispuestos a crear personas adictos cueste lo que cueste.

Los datos y el algoritmo son un arma muy poderosa a la hora de manejar la opinión pública, tanto para comprar bienes o servicios como para influenciar en las elecciones

Los ciudadanos más jóvenes desconfían de los medios de prensa, pero no de las redes sociales ni de los influenciadores. ¿Por qué?

Hay una falsa sensación de democratización. Cuando escuchamos o vemos a un influencer o leemos una publicación escrita en una red social, pensamos que estamos en una relación de igualdad. Y es más fácil ser engañado por alguien que crees parecido a ti. Es cierto que hay una crisis grandísima en el periodismo de todo el mundo. En España, está muy mal considerado; es uno de los trabajos más precarios y ninguneados. ¡Y pensemos que el periodista es el intermediario entre el poder y la población! Puede que los medios tampoco sean impecables, pero los periodistas nos hemos formado para esto. Hay estudios que nos dicen que los jóvenes no se informan por periodistas, sino por vídeos de TikTok que encuentran por casualidad. La información de actualidad que obtienen es la que sale de repente, no porque la busquen.

“El algoritmo calcula cuánto tiempo pasas viendo un video, tus comentarios y quiénes son tus amigos” Foto:iStock

¿Qué guardan los datos personales para justificar la riqueza de las empresas tecnológicas?

La gente a veces se confunde. Piensa que los datos personales son su nombre, su teléfono, su dirección. Y no es eso, es algo mucho más íntimo. Tiene que ver con sus deseos, sus miedos, sus inquietudes, sus necesidades. Esto lo sabe el algoritmo a partir de tu comportamiento online: de cómo te relacionas en internet, a qué le das “me gusta”, qué cosas buscas en Google, cuánto tiempo pasas viendo un video, qué comentarios haces y quiénes son tus amigos. A partir de esos datos, el algoritmo es capaz de trazar una radiografía perfecta de quién eres. Podrías decir: ¿qué le importa al algoritmo saber eso? Le importa para, por ejemplo, incluirte en la lista de hombres de 40 años, sin hijos, que no están contentos con su trabajo y que desean viajar, para mandarte publicidad. Se trata de vendernos publicidad muy personalizada, dirigida a nuestras debilidades más íntimas. Esto es un arma muy poderosa a la hora de manejar la opinión pública, tanto para comprar bienes o servicios como para influenciar en las elecciones. Es un poder que permite segmentar la población y establecer perfiles de gente bajo cualquier criterio. Por eso hablamos de una información tan valiosa. Y por eso ellos se están haciendo tan ricos.

LEA TAMBIÉN

¿Cómo pueden mantenerse relevantes los medios de prensa en tiempos del algoritmo?

Es la pregunta del millón. Está claro que la gente no es tonta. Cuando tú ofreces un contenido honesto, de calidad, el público se da cuenta y lo valora. Es verdad que las personas están hartas de lo que reciben por televisión, que parece repetir las mismas cosas todo el tiempo para lavarte el cerebro. Lo vimos con la pandemia, cuando todos los canales decían exactamente lo mismo. Yo creo que la estrategia es apostar por la calidad y defender la dignidad de nuestra profesión.

En su libro, habla también del sesgo del algoritmo en modelos predictivos. ¿Cómo amplifica el algoritmo los prejuicios de los programadores humanos?

El algoritmo no está dotado de conciencia, ni raciocinio, ni principios, ni moral. Son, simplemente, instrucciones matemáticas y es pura estadística. Lo que hace un algoritmo es encontrar patrones en grandes cantidades de datos. Entonces, si los datos con los que lo alimentamos son datos históricos con toda la historia de nuestro racismo, machismo y clasismo, entonces va a reproducirse y magnificarse. En España, por ejemplo, hay un programa utilizado en las cárceles para analizar si le dan o no libertad condicional a un preso. Un estudio mostró que ese sistema arrojaba alrededor del 60 % de falsos positivos. Decía que un preso era peligroso cuando no era verdad. Las personas tendemos a pensar que si la respuesta la da una IA, tiene razón. Creemos que si una máquina ha llegado a esa conclusión luego de procesar todos los datos, no estamos capacitados para llevarle la contraria. Ese es el problema de los sesgos: terminamos delegando nuestras libertades al promedio de todos nuestros aspectos positivos y negativos calculados por una máquina.

LEA TAMBIÉN

¿Cuándo empezamos a delegar a las máquinas esas decisiones tan importantes como el diseño de políticas públicas o decisiones judiciales?

Tenemos el deseo de organizar y mecanizar las cosas. Lo vemos desde la Revolución Industrial. En vez de que un artesano fabrique nuestros zapatos, los produce una fábrica donde hay líneas de producción que pueden ser medidas. Vivimos la continuación lógica de esa mecanización de las tareas anteriormente humanas. Ahora mecanizamos las políticas públicas, las decisiones judiciales, las hipotecas y las pensiones. ¿Por qué se está dejando eso a manos de las máquinas? “En aras de la eficiencia”, responden las administraciones, los gobiernos y las empresas. Se ahorran mano de obra, les sale más barato y les resulta más confiable. Esta es una falacia muy difícil de romper.

Hay personas que van a la cárcel porque una computadora lo confundió con un delincuente. O drones que disparan contra alguien porque su programa de reconocimiento facial lo confundió con un enemigo…

En las leyes debe quedar claro que la última palabra en una decisión de vida o muerte no la puede tener una computadora. Ahora mismo, muchos países intentan prohibir las llamadas armas letales autónomas. Muchos expertos intentan conseguir que esto se regule. Sin embargo, para fines militares no hay límites en el uso de la IA. Además de la legislación, hacen falta personas educadas. Debemos saber que, por ejemplo, si colgamos en nuestras redes sociales fotos de nuestros hijos y nietos, es posible que esas fotos acaben en páginas web de pederastia y pedofilia. Un estudio demuestra que el 50 % de las fotos de menores en estas páginas fueron sacadas de perfiles públicos de redes sociales de los padres.

Libro Esclavos del algoritmo. Foto:Redes sociales.

LEA TAMBIÉN

Sabemos que la desinformación genera dinero para los dueños de las plataformas digitales. Con esta lógica perversa, ¿es posible pensar en una autorregulación?

Para pelear contra la desinformación, nunca podremos tener como aliado a las empresas tecnológicas. Nunca. Las plataformas digitales son empresas privadas y quieren maximizar su beneficio. No están ahí para hacer un bien a la humanidad ni para ser éticas, están para hacer dinero. Por eso, son las empresas más ricas del mundo. Pienso que la solución más efectiva está en cada uno. Sería excelente educar a los niños en algo que a los mayores nos resulta una obviedad: que internet no es la realidad. Que los resultados que me da Google y la información en redes sociales no equivalen a la realidad. La gente debe aprender que no se puede creer en todo lo que diga internet. A partir de ahí, podemos empezar a educarnos en cómo diferenciar una información falsa de una verdadera. Es muy importante que los jóvenes comprendan que hay mucha realidad que se queda fuera de los márgenes de Google.

¿Qué debería incluir esa educación digital crítica para los ‘nativos digitales’?

Que lean los clásicos. Que tengan una formación en humanismo. Contra lo que intuitivamente podríamos pensar, una educación digital crítica no tiene que ver con las computadoras. Ellos ya saben moverse en redes sociales y no hace falta que alguien les enseñe. Se necesita la otra parte: aprender a pensar. ¿Y cómo se aprende a pensar? Pensando, enriqueciéndonos con lo que pensaron otros antes que nosotros. Eso nos ayuda a formarnos, a entender y a cultivar nuestra humanidad en un momento en el que podríamos perderla.

ENRIQUE PLANAS

El Comercio (Perú) – GDA